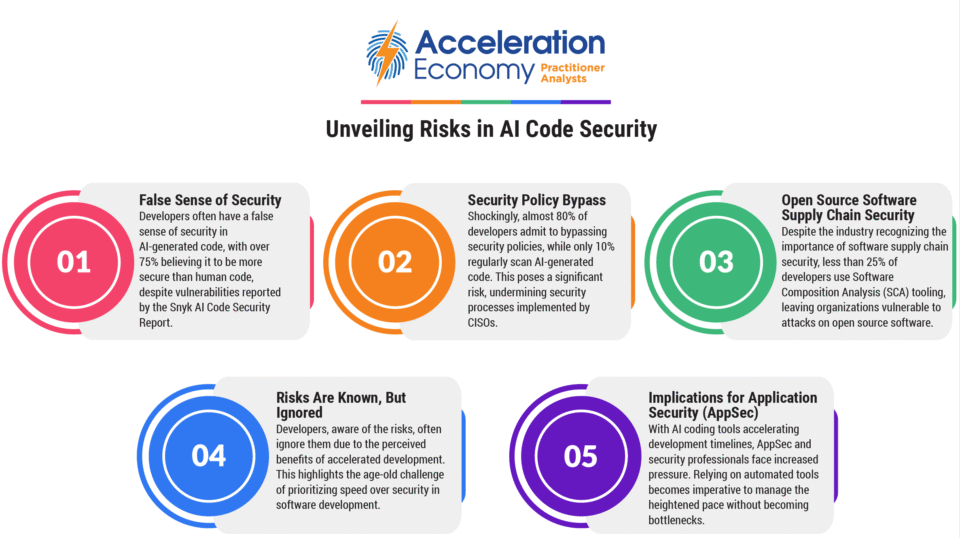

Veracode a publié un rapport mettant en lumière des préoccupations majeures en matière de sécurité liées au code généré par l’intelligence artificielle. L’étude a examiné 80 tâches de codage à travers plus de 100 modèles de langage de grande taille, révélant que l’IA introduit des vulnérabilités de sécurité dans 45 % des cas. Malgré les avancées dans le développement assisté par l’IA, les mesures de sécurité n’ont pas suivi le même rythme, les modèles d’IA optant souvent pour des méthodes de codage peu sécurisées. Cette tendance suscite des inquiétudes alors que les développeurs s’appuient de plus en plus sur l’IA sans définir explicitement les exigences de sécurité, laissant potentiellement des décisions cruciales aux systèmes d’IA.

Les outils d’IA permettent également aux attaquants d’exploiter les vulnérabilités de manière plus efficace, augmentant la sophistication et la rapidité des attaques. La recherche de Veracode a révélé que Java, parmi d’autres langages, présente le risque le plus élevé, le code généré par l’IA ne parvenant souvent pas à traiter des vulnérabilités telles que le cross-site scripting et l’injection de journaux. Les modèles d’IA plus grands ne surpassent pas significativement les plus petits en matière de sécurité, indiquant un problème systémique.

Pour atténuer ces risques, Veracode recommande d’intégrer des outils alimentés par l’IA dans les flux de travail de développement pour traiter les failles de sécurité en temps réel. Les organisations sont encouragées à adopter des stratégies de gestion des risques complètes, incluant l’analyse statique et l’analyse de composition logicielle, pour empêcher que les vulnérabilités n’atteignent la production. Alors que le développement piloté par l’IA continue d’évoluer, il est crucial de maintenir la sécurité comme une priorité afin d’éviter l’accumulation d’une dette de sécurité.